IoT-Technologieentwickler dürfen sich in Sachen KI und Edge-Computing nicht täuschen lassen

Seien Sie vorsichtig mit der Cloud. Sie ist nicht perfekt.

Die IoT-Gemeinschaft (Internet der Dinge) preist die Vorteile der Cloud schon seit langem an. Seine Fähigkeit, große Datenmengen zu verarbeiten, zu speichern und zu verbreiten, ist beispiellos. Die Cloud leidet jedoch unter einer wesentlichen Einschränkung, die den ständig wachsenden Fluss von Bits und Bytes auf der Welt behindert: die hohe Latenz, die durch die Up- und Download-Bandbreiten entsteht.

Denken Sie an einen Ingenieur, der automatisierte industrielle Systeme oder ein autonomes Fahrzeug entwickelt. Diese industriellen IoT-Systeme (IIoT) erzeugen eine riesige Menge an Daten, während ihre Arbeitsumgebungen eine nahtlose Kommunikation und schnelle Reaktionszeiten erfordern. Diese Produkte können nicht Hunderte von Millisekunden darauf warten, dass Daten in die Cloud gesendet, verarbeitet, berechnet, interpretiert und dann zurückgeschickt werden. Jede Verzögerung könnte eine Katastrophe bedeuten.

Wenn jedoch die meisten Daten über Edge-Computing in der Nähe oder auf dem Gerät verarbeitet werden könnten, ließen sie sich zehnmal schneller auswerten. Dieses Problem der geringen Latenz ist einer der Gründe, warum Dimension Market Research schätzt, dass der Markt für Edge-Computing bis 2033 etwa 702,8 Mrd. US-Dollar erreichen wird.

Obwohl Unterhaltungselektronik in Arbeitsumgebungen mit geringeren Anforderungen eingesetzt wird, können Ingenieure dennoch davon ausgehen, dass die Anforderungen der Verbraucher diese Geräte in eine ähnliche Richtung treiben werden.

Kurz gesagt: Da KI, maschinelles Lernen (ML), Augmented Reality (AR) und Virtual Reality (VR) sowohl bei Verbrauchern als auch in der Industrie immer beliebter werden, werden immer weniger Daten - pro Gerät - an die Cloud gesendet und immer mehr Daten am Rand verarbeitet.

Was Ingenieure brauchen, um den Edge-Computing-Trends voraus zu sein

Es liegt auf der Hand, dass Ingenieure, die IoT-Geräte entwerfen, das Edge-Computing nicht länger verschlafen dürfen. Auch wenn es für einige Geräte weiterhin optimal sein wird, alle Daten in die Cloud zu senden, wird Edge-Computing für die meisten Produktdesigns eine Notwendigkeit oder zumindest eine Überlegung sein.

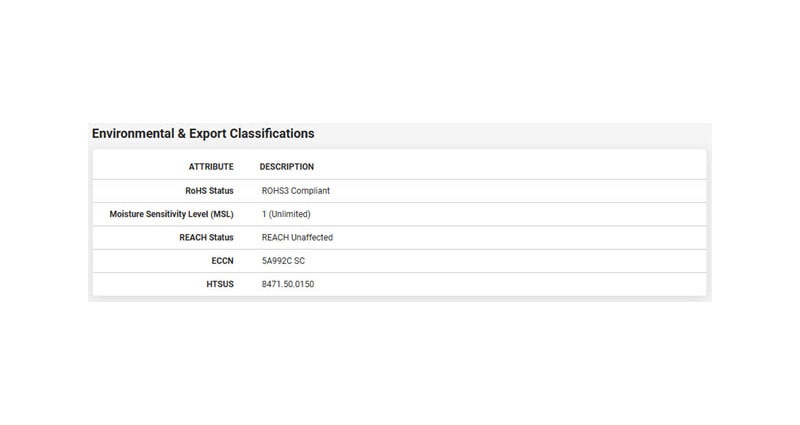

Dies bedeutet, dass Ingenieure Anbieter wie Seeed Technology, die die EdgeBox-RPI-200 anbieten, in Betracht ziehen müssen. Laut Datenblatt des Geräts ist der Einplatinencomputer für Cloud- und IoT-Anwendungen in rauen Industrieumgebungen optimiert. Er basiert auf dem Raspberry Pi CM4 ARM Cortex und bietet einen 1,5 GHz Quad-Core und 4 GB RAM.

Das Gerät kann also vor Ort Daten verarbeiten, auf der Grundlage dieser Daten eigene Entscheidungen treffen und dann die Cloud darüber informieren, was passiert ist.

Wie entwickeln Ingenieure die Zukunft von KI, IoT und Edge Computing?

Dies alles wirft die Frage auf: Wie könnte ein intelligentes, KI-fähiges IIoT-System mit Edge-Computing-Funktionen aussehen? Nun, es könnte unserem eigenen Gehirn ähneln, wenn wir einer Spinne begegnen.

Das Edge-Computing kann sich ähnlich verhalten wie die inneren Teile des Gehirns: Es empfängt Informationen und reagiert sofort, ohne dass der Rest des Gehirns über die Spinne zu sehr ins Detail gehen muss. Die Person schreit auf, ihr Herz schlägt schneller und sie ist in höchster Alarmbereitschaft. Auf dem IoT-Gerät ähnelt dies einem KI- oder ML-Algorithmus, der auf aktuelle Daten reagiert. Wenn er sieht, dass ein Teil in der Produktion nicht den Vorgaben entspricht, informiert er die Geräte, um es vom Band zu nehmen, und ein Mensch kann dann das Teil untersuchen, um festzustellen, ob es so schlecht ist, wie der Algorithmus sagt.

Betrachten wir nun wieder das Gehirn. Nach dem anfänglichen Erschrecken und der Reaktion werden bald auch die äußeren Teile des Gehirns reagieren. Es bewertet, was passiert ist, die Reaktion und weist dann das innere Gehirn an, sich zu beruhigen - weil es nur eine Hausspinne ist - oder weiter in Panik zu geraten - weil sie giftig aussieht. Für das IoT-Gerät könnte dies so aussehen, dass die verarbeiteten Daten an die Cloud gesendet werden. Die Cloud könnte dann die vom Algorithmus berechnete Antwort und das Ergebnis des vom Band genommenen Teils (gut oder schlecht) verwenden und diese Informationen zur Verfeinerung des KI-Algorithmus nutzen.

Die einzigen Daten, die an die Cloud gesendet werden, sind die minimalen Datenmengen, die zur Aktualisierung des KI-Modells benötigt werden. In der Zwischenzeit muss die Cloud nur noch den neu optimierten Algorithmus an das Gerät zurücksenden. Diese Einrichtung optimiert daher die begrenzte Bandbreite, mit der IoT-Ingenieure arbeiten müssen.

Have questions or comments? Continue the conversation on TechForum, Digi-Key's online community and technical resource.

Visit TechForum