Verbesserung der Intralogistik zur Optimierung und Beschleunigung der Lieferketten für Industrie 4.0 - Teil 2 von 2

Zur Verfügung gestellt von Nordamerikanische Fachredakteure von DigiKey

2023-09-22

In Teil 1 dieser Serie über Intralogistik wurden Fragen erörtert, die damit zusammenhängen, wie autonome mobile Roboter (AMR) und fahrerlose Transportsysteme (FTS) auf Systemebene für die Umsetzung der Intralogistik und den schnellen und sicheren Transport von Materialien nach Bedarf eingesetzt werden. Im Fokus dieses Artikels stehen Anwendungsfälle und die Art und Weise, wie AMR und AGV Sensoren nutzen, um Artikel zu identifizieren und zu verfolgen, und wie maschinelles Lernen (ML) und künstliche Intelligenz (KI) die Materialidentifikation, -bewegung und -lieferung in Lagern und Produktionsanlagen unterstützen.

In der Intralogistik (internen Logistik) werden autonome mobile Roboter (AMR) und fahrerlose Transportfahrzeuge (FTS) eingesetzt, um Materialien in Lagern und Anlagen der Industrie 4.0 effizient zu bewegen. Um Lieferketten zu rationalisieren und zu beschleunigen, müssen Intralogistiksysteme den aktuellen Standort des Materials, den beabsichtigten Bestimmungsort des Materials und den sichersten, effizientesten Weg des Materials zum Ziel kennen. Diese optimierte Navigation erfordert eine Vielzahl von Sensoren.

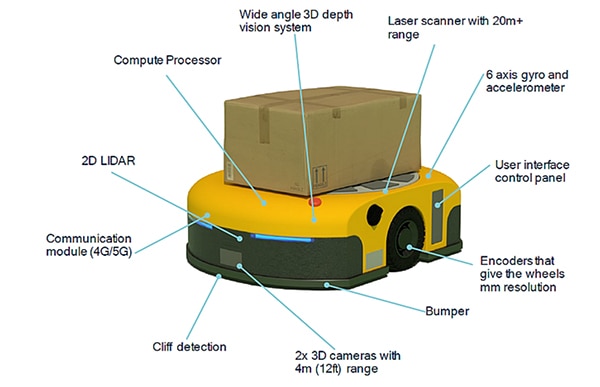

In Intralogistiklösungen verwenden FTS und AMR Sensoren, um ihr Situationsbewusstsein zu verbessern. Eine Vielzahl von Sensoren bietet Sicherheit für das Personal in der Nähe, Schutz für andere Ausrüstungen sowie eine effiziente Navigation und Lokalisierung. Je nach Anwendungsanforderungen können Sensortechnologien für AMR Kontaktsensoren wie in Stoßfänger eingebaute Endschalter, 2D- und 3D-Lichterkennungs- und -entfernungsmesser (LiDAR), Ultraschallsensoren, 2D- und Stereokameras, Radar, Encoder, Trägheitsmesseinheiten (inertial measurement units, IMUs) und Fotozellen umfassen. Zu den Sensoren für FTS können magnetische, induktive oder optische Liniensensoren sowie in Stoßstangen eingebaute Endschalter, 2D-LiDAR und Encoder gehören.

Der erste Artikel dieser Serie befasst sich mit der Frage, wie AMR und FTS auf Systemebene für die Umsetzung der Intralogistik und den effizienten bedarfsgerechten Transport von Materialien eingesetzt werden.

Dieser Artikel konzentriert sich auf die Sensorfusion und darauf, wie AMR und FTS Kombinationen von Sensoren plus KI/ML für Lokalisierung, Navigation und Betriebssicherheit einsetzen. Er beginnt mit einem kurzen Überblick über die in FTS anzutreffenden Sensoren, untersucht die Algorithmen für die Roboterpose und die simultane Ortung und Kartierung (simultaneous location and mapping, SLAM) mit Hilfe der Sensorfusion, betrachtet, wie SLAM-Schätzungen mit Scan-to-Map-Matching und Scan-to-Scan-Matching-Techniken verbessert werden können, und schließt mit einem Blick darauf, wie die Sensorfusion zum sicheren Betrieb von AMR und FTS beiträgt. DigiKey unterstützt Entwickler mit einer breiten Auswahl an Sensoren und Schaltern für Robotik und andere industrielle Anwendungen in all diesen Anwendungsfällen.

Im Bereich von Sensoren und Sensorfusion, KI, ML und Funkkonnektivität wird eine Reihe von Sensoren benötigt, um den autonomen Betrieb und die Sicherheit von AMR zu gewährleisten. Auch wenn die Leistungsanforderungen für FTS geringer sind, benötigen sie dennoch mehrere Sensoren, um für einen sicheren und effizienten Betrieb zu sorgen. Es gibt zwei übergeordnete Kategorien von Sensoren:

- Propriozeptive Sensoren messen roboterinterne Werte wie Raddrehzahl, Beladung, Batterieladung und so weiter.

- Exterozeptive Sensoren liefern Informationen über die Umwelt des Roboters, wie z. B. Abstandsmessungen, die Position von Orientierungspunkten und die Identifizierung von Hindernissen, wie z. B. Personen, die den Weg des Roboters betreten.

Die Sensorfusion in FTS und AMR beruht auf Kombinationen von propriozeptiven und exterozeptiven Sensoren. Beispiele für Sensoren in AMR sind (Abbildung 1):

- Laserscanner zur Objekterkennung mit einer Reichweite von 20 Metern (m) und mehr

- Trägheitsmesseinheit mit einem 6-Achsen-Gyroskop und -Beschleunigungsmesser und manchmal auch einem Magnetometer

- Encoder mit einer Auflösung im Millimeterbereich (mm) an den Rädern

- Kontaktsensor wie ein Mikroschalter im Stoßfänger, der die Bewegung sofort stoppt, wenn ein unerwartetes Objekt berührt wird

- Zwei nach vorn gerichtete 3D-Kameras mit einer Reichweite von 4 m

- Nach unten gerichteter Sensor zur Erkennung der Kante von Plattformen (sogenannte Absatzerkennung)

- Kommunikationsmodule für die Konnektivität und optional mit Bluetooth-Erkennung von Ankunftswinkel (angle of arrival AoA) und Abgangswinkel (angle of departure, AoD) für Echtzeit-Ortungsdienste (real-time location services, RTLS) oder 5G-Sende-/Empfangspunkte (Transmission Points/Reception Points, TRP), um ein Raster mit Zentimetergenauigkeit zu erstellen

- 2D-LIDAR zur Berechnung der Nähe von Hindernissen vor dem Fahrzeug

- 3D-Weitwinkel-Bildverarbeitungssystem zur Identifizierung und Ortung von Objekten

- Leistungsstarker integrierter Prozessor für Sensorfusion, KI und ML

Abbildung: AMR-Beispiel, das die Vielfalt und Positionen der eingebetteten Sensoren zeigt. (Bildquelle: Qualcomm)

Abbildung: AMR-Beispiel, das die Vielfalt und Positionen der eingebetteten Sensoren zeigt. (Bildquelle: Qualcomm)

Roboterpose und Sensorfusion

Die AMR-Navigation ist ein komplexer Prozess. Einer der ersten Schritte ist, dass der AMR weiß, wo er sich befindet und in welche Richtung er schaut. Diese Kombination von Daten wird als Pose des Roboters bezeichnet. Das Konzept der Pose lässt sich auch auf die Arme und Endeffektoren mehrachsiger stationärer Roboter anwenden. Bei der Sensorfusion werden Eingänge von der Trägheitsmesseinheit, Encodern und anderen Sensoren kombiniert, um die Pose zu bestimmen. Der Pose-Algorithmus schätzt die x- und y-Position des Roboters und den Ausrichtungswinkel θ, mit Bezug auf die Koordinatenachsen. Die Funktion q = (x, y, θ) definiert die Pose des Roboters. Für AMR haben die Informationen über die Pose eine Vielzahl von Verwendungszwecken, unter anderem:

- Die Pose eines Eindringlings, z. B. einer Person, die sich dem Roboter nähert, relativ zu einem externen Referenzrahmen oder relativ zum Roboter

- Die geschätzte Pose des Roboters, nachdem er sich mit einer bestimmten Geschwindigkeit für eine vorgegebene Zeit bewegt hat

- Berechnung des Geschwindigkeitsprofils, das der Roboter benötigt, um sich von seiner aktuellen Pose in eine zweite Pose zu begeben

Pose ist eine vordefinierte Funktion in mehreren Entwicklungsumgebungen für Robotersoftware. Das Paket robot_pose_ekf ist zum Beispiel im Robot Operating System (ROS) enthalten, einer Open-Source-Entwicklungsplattform. Das Paket robot_pose_ekf kann verwendet werden, um die 3D-Pose eines Roboters auf der Grundlage von (partiellen) Posemessungen verschiedener Sensoren zu schätzen. Es nutzt einen erweiterten Kalman-Filter mit einem 6D-Modell (3D-Position und 3D-Ausrichtung), um Messungen des Encoders für die Raddrehzahlmessung, einer Kamera für die visuelle Geschwindigkeitsmessung und der Trägheitsmesseinheit zu kombinieren. Da die verschiedenen Sensoren mit unterschiedlichen Raten und Latenzen arbeiten, ist es bei robot_pose_ekf nicht erforderlich, dass alle Sensordaten kontinuierlich oder gleichzeitig zur Verfügung stehen. Jeder Sensor wird zur Posenschätzung mit einer Kovarianz genutzt. Robot_pose-ekf erkennt die verfügbaren Sensorinformationen zu einem beliebigen Zeitpunkt und passt sich entsprechend an.

Sensorfusion und SLAM

In vielen Umgebungen, in denen AMR arbeiten, gibt es variable Hindernisse, die sich von Zeit zu Zeit bewegen können. Auch wenn eine grundlegende Karte der Anlage nützlich ist, braucht es mehr. Wenn sie sich in einer Industrieanlage bewegen, benötigen AMR nicht nur Informationen über die Pose, sondern auch SLAM, um einen effizienten Betrieb zu gewährleisten. SLAM unterstützt die Navigation mit einer Echtzeit-Kartierung der Umgebung. Zwei grundlegende Ansätze für SLAM sind:

- Visuelles SLAM mit Kombination aus Kamera und Trägheitsmesseinheit

- LiDAR-SLAM mit Kombination aus Lasersensor wie 2D- oder 3D-LiDAR und Trägheitsmesseinheit

LiDAR-SLAM kann genauer sein als visuelles SLAM, ist aber im Allgemeinen teurer in der Umsetzung. Alternativ kann 5G zur Bereitstellung von Ortungsinformationen verwendet werden, um visuelle SLAM-Schätzungen zu verbessern. Der Einsatz privater 5G-Netzwerke in Lagern und Fabriken kann eingebettete Sensoren für SLAM unterstützen. Einige AMR implementieren eine präzise Gebäudepositionsbestimmung unter Verwendung von 5G-Sende-/Empfangspunkten (TRP), um ein Raster für zentimetergenaue Genauigkeit auf der x-, y- und z-Achse zu erstellen.

Eine erfolgreiche Navigation hängt von der Fähigkeit eines AMR ab, sich an die veränderlichen Umgebungselemente anzupassen. Navigation kombiniert visuelles SLAM und/oder LiDAR-SLAM sowie Überlagerungstechnologien wie 5G-TRP und ML, um Veränderungen in der Umgebung zu erkennen und den Standort ständig zu aktualisieren. Sensorfusion unterstützt SLAM auf verschiedene Weise:

- Kontinuierliche Aktualisierung des räumlichen und semantischen Modells der Umgebung auf der Grundlage der Eingänge verschiedener Sensoren unter Verwendung von KI und ML

- Identifizierung von Hindernissen, wodurch die Algorithmen zur Bahnplanung in die Lage versetzt werden, die erforderlichen Anpassungen vorzunehmen und den effizientesten Weg durch die Umgebung zu finden

- Implementierung des Pfadplans, der eine Echtzeitsteuerung zur Änderung des geplanten Pfads, einschließlich der Geschwindigkeit und Richtung des AMR, bei Veränderungen der Umgebung erfordert

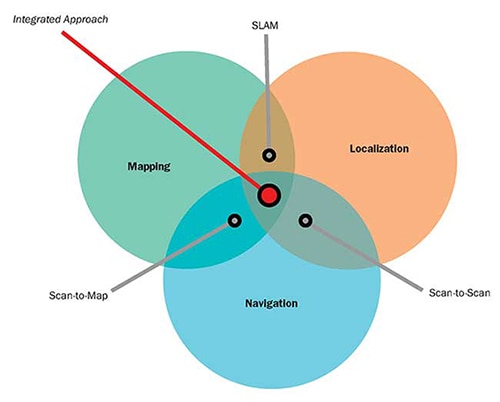

Wenn SLAM nicht genug ist

SLAM ist ein wichtiges Werkzeug für eine effiziente AMR-Navigation, aber SLAM allein reicht nicht aus. Wie die Pose-Algorithmen wird auch SLAM mit einem erweiterten Kalman-Filter implementiert, der geschätzte Werte liefert. Die von SLAM geschätzten Werte erweitern die Pose-Daten und fügen unter anderem Linear- und Rotationsgeschwindigkeiten sowie lineare Beschleunigungen hinzu. Die SLAM-Schätzung ist ein zweistufiger Prozess: Im ersten Schritt werden die Vorhersagen mit Hilfe der internen Sensor-Analytik auf der Grundlage physikalischer Bewegungsgesetze erstellt. Der nächste Schritt bei der SLAM-Schätzung erfordert die Abfrage externer Sensoren, um die ersten Schätzungen zu verfeinern. Dieser zweistufige Prozess hilft dabei, kleine Fehler zu beseitigen und zu korrigieren, die im Laufe der Zeit kompiliert werden und zu erheblichen Fehlern führen können.

SLAM hängt von der Verfügbarkeit von Sensoreingängen ab. In einigen Fällen kann relativ kostengünstiges 2D-LiDAR nicht funktionieren, z. B. wenn sich keine Objekte in der direkten Sichtlinie des Sensors befinden. In diesen Fällen können 3D-Stereokameras oder 3D-LiDAR die Performance des Systems verbessern. 3D-Stereokameras oder 3D-LiDAR sind jedoch teurer und benötigen mehr Rechenleistung für die Implementierung.

Eine weitere Alternative ist die Verwendung eines Navigationssystems, das SLAM mit Scan-to-Map- und Scan-to-Scan-Matching-Techniken umfasst, die nur mit 2D-LiDAR-Sensoren implementiert werden können (Abbildung 2):

- Beim Scan-zo-Map-Matching werden LiDAR-Entfernungsdaten verwendet, um die Position des AMR durch Abstimmung der Entfernungsmessungen mit einer gespeicherten Karte zu schätzen. Die Wirksamkeit dieser Methode hängt von der Genauigkeit der Karte ab. Sie weist keine zeitliche Abweichung auf, kann aber in sich wiederholenden Umgebungen zu Fehlern führen, die schwer zu erkennen sind, diskontinuierliche Änderungen der wahrgenommenen Position verursachen und schwer zu beheben sind.

- Beim Scan-to-Scan-Matching werden sequenzielle LiDAR-Entfernungsdaten genutzt, um die Position eines AMR zwischen Scans zu schätzen. Diese Methode liefert aktualisierte Standort- und Poseinformationen für den AMR unabhängig von einer bestehenden Karte und kann bei der Kartenerstellung nützlich sein. Es handelt sich jedoch um einen inkrementellen Algorithmus, der im Laufe der Zeit einer Drift unterworfen sein kann, ohne dass die daraus resultierenden Ungenauigkeiten erkannt werden können.

Abbildung 2: Scan-to-Map- und Scan-to-Scan-Matching-Algorithmen können zur Ergänzung und Verbesserung der Performance von SLAM-Systemen eingesetzt werden. (Bildquelle: Aethon)

Abbildung 2: Scan-to-Map- und Scan-to-Scan-Matching-Algorithmen können zur Ergänzung und Verbesserung der Performance von SLAM-Systemen eingesetzt werden. (Bildquelle: Aethon)

Sicherheit braucht Sensorfusion

Sicherheit ist ein Hauptanliegen bei FTS und AMR und erfordert die Einhaltung mehrerer Normen. Zum Beispiel der Norm B56.5 – 2019 von American National Standards Institute / Industrial Truck Standards Development Foundation (ANSI/ITSDF) zur Sicherheit fahrerloser, automatisch geführter Industriefahrzeuge und automatisierter Funktionen von bemannten Industriefahrzeugen, der Norm R15.08-1-2020 von ANSI/Robotic Industrial Association (RIA) zu den Sicherheitsanforderungen für mobile Industrieroboter, mehrerer Normen der International Standards Organization (ISO) und anderer.

Der sichere Betrieb von FTS und AMR erfordert eine Sensorfusion, die sicherheitszertifizierte 2D-LiDAR-Sensoren (manchmal auch Sicherheitslaserscanner genannt) mit Encodern an den Rädern kombiniert. Das 2D-LiDAR unterstützt gleichzeitig zwei Erfassungsreichweiten, kann einen Erfassungswinkel von 270° haben und koordiniert sich mit der von den Encodern gemeldeten Fahrgeschwindigkeit. Wenn ein Objekt im weiteren Erfassungsbereich (je nach Sensor bis zu 20 m) erkannt wird, kann das Fahrzeug bei Bedarf abgebremst werden. Wenn das Objekt in den näheren Erfassungsbereich in der Fahrlinie eindringt, stoppt das Fahrzeug seine Fahrt.

Sicherheitslaserscanner werden oft in Sätzen zu vier Sensoren verwendet, mit einem an jeder Ecke des Fahrzeugs. Sie können als eine Einheit arbeiten und direkt mit der Sicherheitssteuerung des Fahrzeugs kommunizieren. Die Scanner sind für den Einsatz in Anwendungen der Sicherheitskategorie 3, der Leistungsstufe d (PLd) und der Sicherheitsintegritätsstufe 2 (SIL2) erhältlich und zertifiziert und befinden sich in einem Gehäuse der Schutzart IP65, das für die meisten Anwendungen im Außen- und Innenbereich geeignet ist (Abbildung 3). Die Scanner verfügen über einen Eingang für die Informationen eines Inkrementalgebers an den Rädern zur Unterstützung der Sensorfusion.

Abbildung 3: 2D-LiDAR-Sensoren wie dieser können mit Encodern an den Rädern in einem Sensorfusionssystem kombiniert werden, das einen sicheren Betrieb von AMR und FTS ermöglicht. (Bildquelle: Idec)

Abbildung 3: 2D-LiDAR-Sensoren wie dieser können mit Encodern an den Rädern in einem Sensorfusionssystem kombiniert werden, das einen sicheren Betrieb von AMR und FTS ermöglicht. (Bildquelle: Idec)

Fazit:

Intralogistik unterstützt schnellere und effizientere Lieferketten in Lagern und Fabriken der Industrie 4.0. AMR und FTS sind wichtige Werkzeuge für die Intralogistik, um Material zeitgesteuert und sicher von einem Ort zum anderen zu bringen. Sensorfusion ist notwendig, um die Funktionen von AMR und FTS zu unterstützen, wie z. B. die Bestimmung der Pose, die Berechnung von SLAM-Daten, die Verbesserung der Navigationsleistung durch die Abstimmung von Scans mit Karten und von Scans mit Scans und die Gewährleistung der Sicherheit für Personen und Objekte in der gesamten Anlage.

Haftungsausschluss: Die Meinungen, Überzeugungen und Standpunkte der verschiedenen Autoren und/oder Forumsteilnehmer dieser Website spiegeln nicht notwendigerweise die Meinungen, Überzeugungen und Standpunkte der DigiKey oder offiziellen Politik der DigiKey wider.